Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™

Acelere, simplifique e valide inferência de aprendizagem profunda

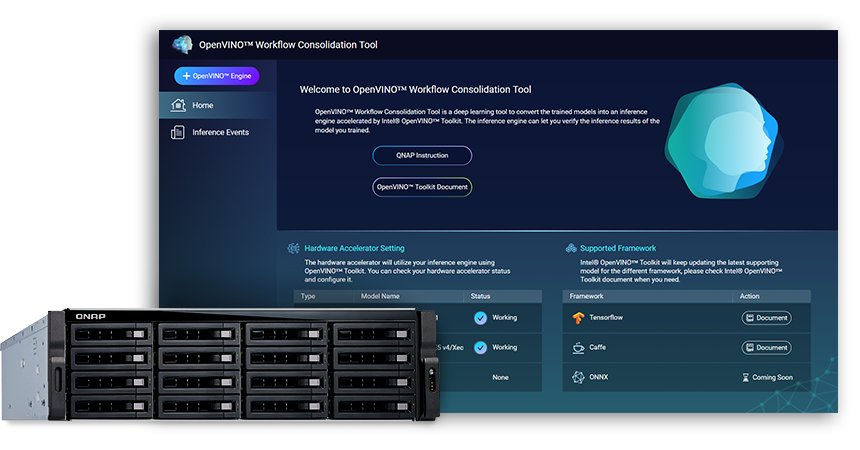

A Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™ (OWCT) (disponível no QTS App Center) é uma ferramenta de aprendizagem profunda para converter modelos treinados em um serviço de inferência acelerado pela Distribuição da Intel® do Kit de Ferramentas OpenVINO™ (Otimização de Inferência Visual e Rede Neural Aberta), que ajuda a distribuir soluções de visão de máquina que usam IA de forma econômica.

QNAP oferece Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™ para capacitar o QNAP NAS como um servidor de inferência.

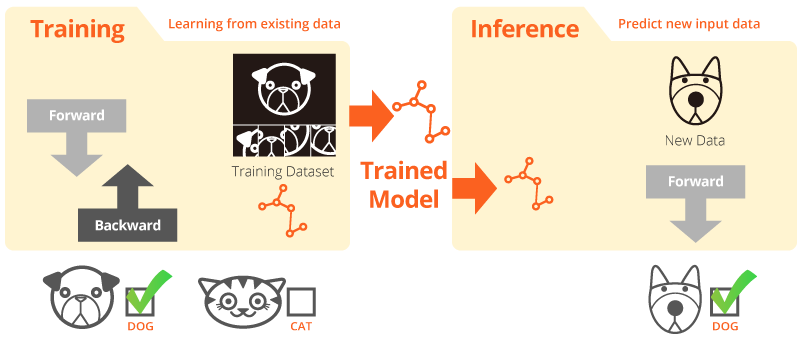

Treinamento e inferência

“Treinamento” é quando o sistema aprende com dados existentes. “Inferência” é quando um modelo treinado é usado para fazer previsões úteis com dados reais.

Distribuição da Intel® do Kit de Ferramentas OpenVINO™

O kit de ferramentas OpenVINO™ ajuda a acelerar o desenvolvimento da visão computacional de alto desempenho e da aprendizagem profunda em aplicações de visão. Ele habilita a aprendizagem profunda em aceleradores de hardware e a execução heterogênea facilitada em plataformas da Intel®, incluindo CPU, GPU, FPGA e VPU. Os principais componentes incluem:

- O Kit de Ferramentas de Desenvolvimento de Aprendizagem Profunda da Intel® (Otimizador de Modelo e Mecanismo de Inferência)

- Funções otimizadas para OpenCV* e OpenVX*

- Oferece mais de 15 códigos de exemplo e modelos pré-treinados para fácil implantação

Fonte: Intel

Sua inferência de IA para visão computacional, agora mais rápida!

Principais benefícios de usar a Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™ (OWCT):

-

Aceleração

O kit de ferramentas OpenVINO™ contém uma biblioteca de código aberto que ajuda a reduzir o tempo de desenvolvimento e simplifica a inferência de aprendizagem profunda e a implantação de soluções orientadas à visão.

-

Otimização

O Otimizador de Modelos converte modelos treinados em uma representação intermediária (IR) e realiza otimizações básicas para aumentar a eficiência da inferência.

-

GUI

A OWCT usa uma GUI que permite que os usuários utilizem os recursos do OpenVINO™ com facilidade, exibam elementos visuais e baixem o resultado da inferência.

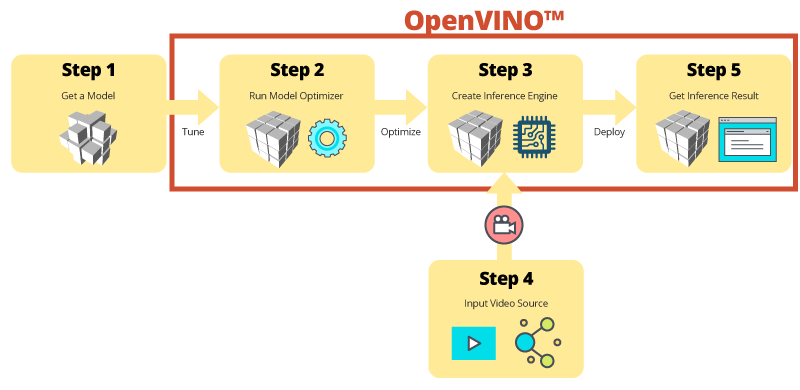

Inferência passo a passo com a OWCT

A OWCT consolida todos os recursos necessários do OpenVINO™ para ajudar você a criar o Mecanismo de Inferência e analisar os resultados de inferência do modelo. Basta seguir o assistente do aplicativo e configurar tudo em poucas etapas!

Use modelos pré-treinados para agilizar o desenvolvimento

Além de pesquisar modelos ou treinar seus próprios modelos, o kit de ferramentas do OpenVINO™ também oferece modelos pré-treinados otimizados da Intel® em aplicativos de usuário, o que é conhecido como Mecanismo de Inferência.

-

O kit de ferramentas OpenVINO™ inclui dois conjuntos de modelos otimizados. Você pode adicionar esses modelos diretamente ao seu ambiente e acelerar seu desenvolvimento.

Modelos pré-treinados:

- Reconhecimento de idade e sexo

- Interseção

- Posição da cabeça

- Barreiras de segurança

- Reconhecimento de características de veículos

- ...e muito mais

-

Importe seus próprios modelos treinados para aproveitar a otimização do Otimizador de Modelos e do Mecanismo de Inferência. Assim, você poderá realizar inferência com facilidade para visão computacional em arquiteturas atuais ou futuras da Intel® para atender a todas as suas necessidades de IA. O kit de ferramentas OpenVINO™ funciona com modelos pré-treinados que usam os formatos Caffe e TensorFlow.

QNAP NAS como servidor de inferência

O kit de ferramentas OpenVINO™ amplia as cargas de trabalho entre os componentes de hardware da Intel® (incluindo aceleradores) e maximiza o desempenho. Quando usado com a Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™, os sistemas QNAP NAS com processadores Intel apresentam um Servidor de Inferência ideal que ajuda as organizações a criar um sistema de inferência com rapidez. Oferecendo um otimizador de modelos e um mecanismo de inferência, o kit de ferramentas OpenVINO™ é fácil de usar e flexível para visão computacional de alto desempenho e baixa latência que otimiza a inferência de aprendizado profundo. Desenvolvedores de IA podem implantar modelos treinados em um QNAP NAS para inferência e instalar aceleradores de hardware baseados em plataformas da Intel® a fim de maximizar o desempenho da realização de inferência.

Mecanismo de inferência fácil de gerenciar

-

Carregue um arquivo de vídeo

-

Baixe o resultado da inferência

Maior desempenho com placas aceleradoras

O kit de ferramentas OpenVINO™ é compatível com execução heterogênea em aceleradores de visão computacional (CPU, GPU, FPGA e VPU) usando uma API comum para otimização voltada a dispositivos específicos.

-

AceleradorFPGA

- FPGA Intel® Arria® 10 GX 1150

- PCIe 3.0 x8

- Slots duplos, compactos, da metade da altura

-

AceleradorVPU

- Solução Intel® Movidius™

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Slot único compacto da metade do tamanho

Série TVS-x72XU |

Série TVS-x72XT |

TS-2888X |

|---|---|---|

Nota:

- O QTS 4.4.0 (ou posterior) e o OWCT v1.1.0 são necessários para o QNAP NAS.

- Para usar o processamento da placa FPGA no QNAP NAS, a função de passagem de VM será desativada. Para evitar o risco de perda de dados, conclua todas as tarefas do NAS em andamento antes da reinicialização.

- Modelos suportados completos (Verifique Nota de lançamento do OWCT)

- TVS-x72XT: CPU, iGD, VPU (Observação: TVS-472XT não é suportado)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO e o logotipo OpenVINO são marcas comerciais da Intel Corporation ou de suas subsidiárias nos Estados Unidos e/ou em outros países.